Einführung

Das Projektteam der Steinbeis Hochschule Berlin ist Mitakteur im Arbeitspaket der Evaluation und fokussiert in seinem AP die formative Evaluation. Durch die formative Evaluation werden Zwischenergebnisse erstellt, die verwendet werden um die Praxis ständig weiterzuentwickeln. Ebenso können Abweichungen der Interventionen und ihrer Wirkungen im Projekt vom Projektmanagementverantwortlichen fortlaufend kontrolliert werden (vgl. Bortz, Döring 2006, S. 110).

Das Projektteam führt selbst keine Evaluationen in den GeDiReMo Projektvorhaben durch, sondern forscht nach effizienten und effektiven Evaluationsanwendungen aus den Modellvorhaben sowie aus anderen Projekten mit Bezug Gesundheit.

Das Ziel des Teilprojektes liegt in der Unterstützung der Akteure und der Entwicklung einer gezielt, strukturiert, vermittelnd sowie eingreifend formativen Evaluationsforschung. Diese soll Verläufe und Prozesse im Projekt näher untersuchen. Dabei sind folgende Fragestellungen von Interesse:

- In welchem Maße kann durch formative Evaluation Einfluss auf Projekte im Gesundheitswesen genommen werden?

- Wann und mit welchen Methoden der formativen Evaluation kann Einfluss auf Teilzielabweichungen in Projekten erfolgen?

- Welche Interventionsmöglichkeiten und Methoden bei Nichterreichung von Teilzielabweichungen in Projekten gibt es?

- Wie erfolgt die Identifikation von spezifischen Projektprozessen zum positiven und negativen Verlauf des Projektes?

- Kann ein Projektmuster identifiziert werden, welches zur Weiterentwicklung des Projektmanagements beiträgt?

- Welche Erwartungen werden von Projektleitern, Projektkoordinatoren und Konsortialführern in ihren komplexen Gesundheitsprojekten bei der Projektdurchführung und formativen Evaluation an IT-Hilfsmittel gestellt?

- Wie ist die aktuelle Nutzung verschiedener IT-Hilfsmittel in ihren Projekten?

Diese Fragestellungen sind essentiell und können zum Gelingen von Projekten beitragen.

Herausforderungen in der Evaluation von Projekten mit Bezug auf Gesundheit

Eine Vielzahl an Projekten und Maßnahmen wurden und werden im Gesundheitswesen durchgeführt.

Evaluationen im Gesundheitswesen sind infolge konkreter Kontextbeziehungen, unterschiedlicher Evaluationsfelder und der komplizierten Gegebenheiten schwer zu handhaben. Sie stellen alle beteiligten Personen vor große Herausforderungen.

Folgende konkrete Kontextbedingungen im Gesundheitswesen sind entscheidend bei der Planung von Evaluationsprojekten:

- Im Gesundheitswesen wird mit und am Menschen gearbeitet, weshalb dieser Bereich besonders sensibel ist.

- Der Gesundheitssektor wird dadurch vom Wirtschaftsbereich unterschieden, da er sich nicht vorwiegend mit Gütern, Waren und Produkten befasst.

- Die Gesundheitsversorgung wird, wie z.B. der Bereich Bildung, als öffentliche Aufgabe definiert. Im Gesundheitswesen tätige Menschen tragen öffentliche Verantwortung und agieren mit Steuergeldern.

- Die Folgen von Fehlentscheidungen im Gesundheitsbereich zeichnen sich meist sofort und deutlich ab.

- Durch Heterogenität der im Gesundheitswesen Beschäftigten (z.B. Ärzte, Pfleger, Psychologen, Therapeuten, Sozialarbeiter, und weitere Berufe) kann es zu Abstimmungsproblemen kommen. Die uneinheitliche Ausbildung, der unterschiedliche Wissensstand und der entsprechende Berufsstatus haben Einfluss auf die Evaluation.

- Hochspezialisiertes professionelles Wissen im Gesundheitsbereich steht neben Alltags- und Laienwissen im Familienbereich.

- Beschäftigte in der Gesundheitsversorgung agieren zwischen zwei Polen. Einerseits dem hochtechnisierten Bereich und anderseits dem einfühlsamen, persönlichen und therapeutischen Bereich (vgl. Mayring 2009, S. 321 f.).

Erschwerend für Evaluation wirkt weiterhin, dass die Aktivitäten, die es zu evaluieren gilt, sehr unterschiedlich sind.

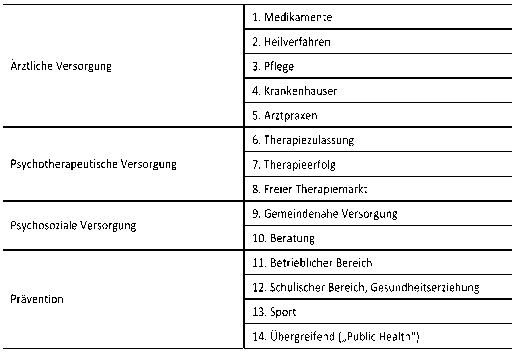

Mayring hat die Evaluationsgegenstände im Gesundheitsbereich in vier große Bereiche sowie in 14 Felder kategorisiert.

Tabelle: Evaluationsgegenstände in 14 Feldern (Mayring 2009, S. 323)

Ebenso sind hierbei die verschiedenen Perspektiven (Anbieter im Gesundheitsmarkt, institutionelle Rahmenbedingungen, Qualität gesundheitsbezogener Angebote) zu berücksichtigen.

Damit wird deutlich, dass bei der Evaluation in diesem sensiblen Bereich besondere Maßstäbe gelten.

Eine Hilfestellung kann hierbei die Nutzung entsprechender Werkzeuge sein. Die Steinbeis Hochschule Berlin/Institut Essen nutzt und empfiehlt, unabhängig ihres AP „formative Evaluation“ im Projekt INDiGeR, entsprechend bewährte Werkzeuge die den Gütekriterien der Evaluationsforschung entsprechen.

Beschreibung zentraler Begrifflichkeiten

Bis vor ca. 20 Jahren wurde Evaluation im deutschsprachigen Raum kaum wahrgenommen und war auf wenige Gesellschaftsbereiche beschränkt. War Evaluation in den 1980-1990er Jahren nur einem kleinen Kreis an Fachexperten vertraut, so ist der Bekanntheitsgrad von Evaluation, ihre Akzeptanz, die Anwendungsbreite und die methodischen Ansätze vielfältiger und konkreter geworden. Evaluation und abgeleitete Wortvarianten haben sich im Sprachgebrauch weit verbreitet und werden mittlerweile in Parlamentsdebatten, Tageszeitungen, Talkshows mit politischen oder gesellschaftlichen Inhalten, Radio- und Fernsehnachrichtensendungen genutzt. Zum Teil wird sogar kritisch von einem Evaluationsboom gesprochen. Abseits der inflationären Ausbreitung des Wortes stellt sich die Frage, was Evaluation nun wirklich ist und was sie zu leisten vermag (vgl. Beywl, Widmer 2009, S. 13-16).

Durch die Verwendung unterschiedlicher Benennungen, Definitionen, verwandter Begriffe, Kontexte und Sprachgebräuche ist es notwendig, den Terminus Evaluation/Evaluationsforschung genauer abzugrenzen. Eine sichere begriffliche Abgrenzung von professioneller und alltäglicher Evaluation ist ebenso notwendig wie ein Mindestmaß an Qualitätssicherung. Probleme können sonst durch den inhaltlich nicht einheitlichen Gebrauch des Evaluationsbegriffes und seiner entsprechenden Fachterminologie auftreten (vgl. Kromrey, 2001, S. 3).

Wissenschaftliche Begleitforschung

Der angewandte Forschungstyp der wissenschaftlichen Begleitforschung untersucht empirisch auf Innovationen gerichtete Modellprojekte oder Modellprogramme. Begleitforschung ist öffentlich finanziert und befristet. Sie wirkt an der Erstellung des Projektkonzeptes und an der Beantragung mit. Begleitforschung überprüft die Projektumsetzung und Zielerreichung. Die Übertragungsfähigkeit auf andere Regionen wird geprüft. Gleichzeitig ist Begleitforschung an zielführenden Veränderungen beteiligt (vgl. Eval-Wiki, 2015).

Bei Initiativen, Projekten und der Begleitforschung mit Bezug auf Gesundheit handelt es sich, wie Roth beschreibt, meist um groß angelegte, mit beträchtlichem finanziellen und auch administrativen Aufwand durchgeführte Untersuchungen (vgl. Roth 1993, S. 252).

In der Regel beziehen sich Begleitforschungen auf die professionelle Praxis. Das sind z.B. Förderprojekte von Regierungen, Modellversuche bzw. Projekte, innovative Praxisansätze oder Fragen der Übertragbarkeit. Hierbei soll die Begleitforschung Informationen generieren, die es ermöglichen, Hilfestellungen bei der Übertragbarkeit, Entscheidungen in Bezug der Fortsetzung von Programmen und Projekten sowie Ansätze der Verbesserungen in der Praxis zu fördern (vgl. Bitzan 2008, S. 336).

Den Modellprojekten wurde eine Begleitforschung zur Seite gestellt die projektbegleitend mit ihnen zusammenarbeiten soll. Sie analysiert die methodischen Ansätze der Modellregionen sowie anderer Projekte und die bei der Umsetzung entstehenden förderlichen und hinderlichen Bedingungen. Die Begleitforschung soll mit den Regionen nutzenorientiert zusammenarbeiten und ihnen ein Angebot zur Praxisreflexion geben (vgl. Sischka 2012, S. 128f).

Evaluation und Evaluationsforschung

In den vielfältigen Definitionen von Evaluation gibt es keinen Konsens. Wottawa und Thierau definieren Evaluationen und Evaluationsforschung nach Suchmann wie folgt:

- „Evaluation (Bewertung): Ist der Prozess der Beurteilung des Wertes eines Produktes, Prozesses oder eines Programmes, was nicht notwendigerweise systematische Verfahren oder datengestützte Beweise zur empirischen Untermauerung einer Beurteilung erfordert.“

- „Evaluation research (Evaluationsforschung): Ist die explizite Verwendung wissenschaftlicher Forschungsmethoden und -techniken für den Zweck der Durchführung einer Bewertung. Evaluationsforschung betont die Möglichkeit des Beweises anstelle der reinen Behauptung bzgl. des Wertes und Nutzens einer bestimmten sozialen Aktivität.“ (Wottawa, Thierau, 1998, S. 13)

Evaluation beinhaltet somit die Festsetzung des Wertes einer Sache. Der Gegenstand und die Methode der Evaluation werden dabei noch nicht festgelegt. Es ist ein zweck- und zielorientierter Prozess eines Evaluationsobjektes. Dagegen werden bei der Evaluationsforschung Informationen durch wissenschaftliche Methoden und empirische Daten erhoben. Dadurch werden Irrtümer und Fehler vermindert und vermieden.

Rossi und Freemann haben 1993 den Begriff Evaluationsforschung wie folgt präzisiert: „Evaluationsforschung beinhaltet die systematische Anwendung empirischer Forschungsmethoden zur Bewertung des Konzeptes, des Untersuchungsplanes, der Implementierung und der Wirksamkeit sozialer Interventionsprogramme“ (zitiert nach Bortz, Döring, 2006, S. 96).

Evaluationsforschung wird nach Balzer als Prozess verstanden, „[…] bei dem nach zuvor festgelegten Zielen und explizit auf den Sachverhalt bezogenen und begründeten Kriterien ein Evaluationsgegenstand bewertet wird. Dies geschieht unter Zuhilfenahme sozialwissenschaftlicher Methoden durch Personen, welche hierfür besonders qualifiziert sind. Das Produkt eines Evaluationsprozesses besteht in der Rückmeldung verwertbarer Ergebnisse in Form von Beschreibungen, begründeten Interpretationen und Empfehlungen an möglichst viele Beteiligte und Betroffene, um den Evaluationsgegenstand zu optimieren und zukünftiges Handeln zu unterstützen“ (Balzer, 2005, S. 16).

Bortz & Döring nutzen statt einer Definition folgende allgemeine Kennzeichen wissenschaftlicher Evaluation:

- Sie dient als Planungs- und Entscheidungshilfe.

- Sie hat etwas mit Bewertung von Handlungsalternativen zu tun.

- Sie ist ziel- und zweckorientiert.

- Sie sollte mit dem aktuellen Stand wissenschaftlicher Forschung abgestimmt sein (vgl. Bortz, Döring, 2006, S. 97 f.).

Die Evaluationsforschung befasst sich somit nicht nur mit Bewertungen, sondern auch mit Maßnahmen oder Interventionen. Dabei kann es eine Vielzahl von Evaluationsobjekten geben. Gegenstände der Evaluation können Personen, Umweltfaktoren, Produkte, Techniken und Methoden, Zielvorgaben, Projekte und Programme, Systeme und Strukturen sowie Forschungen sein. Die Bewertung des Erfolges von gezielt eingesetzten Maßnahmen hängt mit forschenden Tätigkeiten der Evaluationsforschung zusammen. Dazu gehören ebenso Auswirkungen von Wandel in Natur, Kultur, Technik und Gesellschaft und die Analyse bestehender Institutionen oder Strukturen (vgl. DeGEval, 2008, S. 15).

Mayring äußert sich dahingehend, dass Evaluationsforschung Praxisveränderungen überprüfen möchte, ohne selbst einzugreifen (vgl. Mayring, 2002, S. 62). Folgende Merkmale bieten weitere Möglichkeiten, den Begriff Evaluationsforschung vom Begriff Evaluation näher abzugrenzen:

- Evaluationsforschung stützt sich auf wissenschaftliche Methoden der Erhebung und Auswertung.

- Ein eingegrenzter empirisch beschreibbarer Gegenstand wird evaluiert.

- Eine präzise Fragestellung erfolgt, die sich operationalisieren lässt.

- Evaluationsforschung wird von Personen (Evaluatoren) geführt, die angemessene Expertise und Legitimation besitzen (vgl. Reinmann, 2012, S. 5).

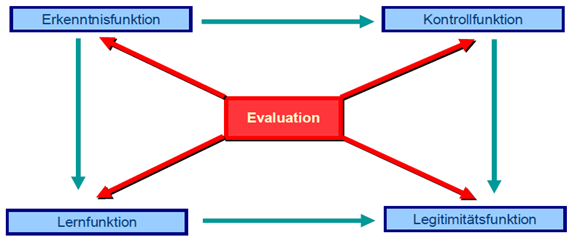

Das Ziel von Evaluation liegt in der Erkenntnisfunktion für Evaluationsgeber und Projektmanagement. Als Kontroll- und Disziplinierungsfunktion wird überprüft, ob alle Beteiligten ihre Aufgaben erfüllen und wie ihr Verhalten ist. Evaluationen tragen zum Dialog mit allen Beteiligten bei und haben somit Lernfunktion. Abschließend kann mit den durch Evaluation gesammelten Daten überprüft werden, welche Ergebnisse mit welchen Mitteln erreicht wurden. Damit hat Evaluation eine Legitimationsfunktion (vgl. Stockmann, 2004, S. 3 f.)

Abbildung: Zielfunktionen der Evaluation (vgl. Stockmann 2005, S. 3)

Formative Evaluation

Auf die verschiedenen Ebenen, Rahmenbedingungen, Akteure und Ausrichtungen von Evaluation wird hier im Einzelnen nicht eingegangen. Dagegen ist die Durchführungsvariante von Evaluation zentraler Aspekt der Ausführungen.

Unter welchen, insbesondere zeitlichen Bedingungen wird eine Evaluation durchgeführt?

Was formative Evaluation bedeutet, was sie zu leisten vermag und wie ihre Anwendung erfolgt, wird weiterführend durch die Gegenüberstellung zweier Evaluationsmodelle verdeutlicht.

Evaluation kann somit formativ sein (Prozessevaluation). Sie liegt vor, wenn die Evaluation während der Abwicklung eines Projektes oder einer Maßnahme erfolgt. Evaluation kann aber auch summativ sein (Ergebnisevaluation). Diese ist zusammenfassend, bilanzierend und ergebnisorientiert in ihrer Bewertung (vgl. Stockmann, 2014, S. 84). Sie beurteilt die Wirksamkeit einer vorgegebenen Intervention (vgl. Bortz, Döring, 2006, S. 110). Summative und formative Evaluationen können auch gleichzeitig durchgeführt werden (systematische Evaluation), wenn ein Projekt von der Planungs- bis zur Transferphase begleitet werden soll (vgl. Wottawa, Thierau, 1998, S. 63).

Nach Scriven wird der Unterschied zwischen formativer und summativer Evaluation am besten mit der Frage beschrieben:

„Was will Evaluation letzten Endes erreichen?“ Ein handlungsorientiertes Beispiel dafür ist der Koch, der die Suppe kostet (formativ) und noch nachsalzen kann, im Gegensatz zum Gast, der sie kostet und abschließend (summativ) bewertet (vgl. Wesseler, 2009, S. 1034 f.).

Formative Evaluation ist somit aktiv gestaltend, prozessorientiert, konstruktiv und kommunikationsfördernd angelegt. Dabei werden Verläufe und Prozesse näher untersucht. Einzelne Zwischenergebnisse einer Evaluation können auf die Praxis angewendet werden. Somit findet eine ständige formende Weiterentwicklung der Praxis statt. Die formative Evaluation erstellt regelmäßig Zwischenergebnisse. Zielsetzung ist, die laufende Intervention zu modifizieren oder zu verbessern. Die Abwicklung der Maßnahme und ihre Wirkung werden damit fortlaufend kontrolliert (vgl. Bortz, Döring, 2006, S. 110).

Verschiedene Definitionen von formativer Evaluation werden publiziert. Einigkeit herrscht darin, dass formative Evaluation das Ziel verfolgt, die Programmdurchführung zu optimieren und die Programmkonzeption zu verbessern. Ebenfalls findet sich die Übereinstimmung, dass ihr Ansatz in der Planung und Vorbereitung eines Programms liegt und sie sich an diejenigen Personen richtet, die mit der Programmkonzeption und -durchführung befasst sind (vgl. Gollwitzer, Jäger, 2007, S. 124).

Formative Evaluation dient somit der Verbesserung laufender Vorhaben und Prozesse. Durch die anschließenden Rückmeldungen von Evaluationserkenntnissen ist eine unmittelbare Nachsteuerung, Modifikation und/oder Optimierung/Verbesserung der laufenden Intervention/Maßnahme über den Rahmen des Vorgegebenen hinaus möglich (vgl. Neitzke et al., 2013, S. 152). Formative Evaluation ist prozessbegleitend und dialogbetont angelegt. Sie wird im Sinne einer kontinuierlichen Qualitätsentwicklung wirksam. Sie hat Ähnlichkeit zu partizipativen Forschungsmethoden. Dort sind die Stakeholder des zu evaluierenden Projektes eingeladen, Einfluss auf die Ausgestaltung des Evaluationsplans und dessen Umsetzung zu nehmen (vgl. Bär, 2013, S. 156).

Formative Evaluation begleitet den Evaluationsgegenstand, zielt auf Verbesserungen ab und kann regelmäßige Rückkopplungen von Ergebnissen in das Projekt vornehmen. Sie hat damit Konsequenzen für den Projektverlauf und wirkt programmformend (vgl. Kromrey, 2006, S. 104 ff.). Elemente der formativen Evaluation sind damit ein fester Bestandteil von Projekten.

Folgende verschiedene Definitionsmerkmale zeichnen formative Evaluationsforschung dabei aus:

- zeitliches Merkmal (findet während der Maßnahme statt),

- Entwicklungsstand (des Gegenstandes der sich in der Entwicklung befindet),

- Adressat (Akteure die Maßnahmen planen, gestalten, und/oder durchführen, evtl. modifizieren),

- Interaktionen (enge Arbeitsbeziehungen zwischen den Betroffenen und Beteiligten),

- Zweck (Entwicklung und/oder Verbesserung, evtl. wissenschaftlicher Erkenntnisgewinn) (vgl. Reinmann 2012, S. 16).

Formative Evaluation ist bei der Entwicklung und Implementierung neuer und innovativer Maßnahmen und Projekte, meist erkundend, angelegt. Sie zielt, neben der Identifizierung von Wirkungsläufen u. a. auf die Vermittlung handlungsrelevanten Wissens (Prozess- und Steuerungswissens) ab. Formative Evaluation sollte während der Entwicklung, Ausgestaltung und Erprobung eines Projektes durchgeführt werden. Enthaltene Komponenten (Aufgaben, Strategien, Abläufe) sowie die daraus resultierenden Prozesse werden dabei in Hinblick auf die Zielsetzung und Wirksamkeit verbessert. Dabei werden Programme mehr als einmal, meist intern, evaluiert. Dadurch gelingt das Aufzeigen von Programmschwächen und damit eine ständige Verbesserung und Weiterentwicklung.

Formative Evaluation ist als analytische Evaluation einzelner Komponenten des Programms angelegt, könnte aber auch als globale Evaluation für das ganze Programm durchgeführt werden. Bei Feinabstimmung und Modifikation bereits laufender und etablierter Programme liefert formative Evaluation hilfreiche Hinweise zu deren Verbesserung. Sie ist dabei informell angelegt (vgl. Bortz, Döring, 2006, S. 110 f.).

Mit formativer Evaluation können nicht nur unterschiedliche Ziele verfolgt, sondern auch unterschiedliche Aufgabenstellungen verbunden werden.

Diese können dazu genutzt werden:

- die Planung von Programmen, Projekten oder Maßnahmen zu verbessern (Ex-ante-Evaluation),

- Durchführungsprozesse zu beobachten (On-going-Evaluation) (vgl. Stockmann, 2004, S. 2–6).

Resultate der formativen Evaluation können als Entscheidungshilfe und Anregung in der Projektdurchführung dienen. Dadurch entsteht eine permanente Qualitätsentwicklung und -sicherung im laufenden Prozess der Praxis (vgl. Hirschmann, Pfaff, 2008, S. 95). Hierbei kann formative Evaluation in der Durchführung die Rolle eines Probedurchlaufes übernehmen. Diese Form wurde von Scriven im Kontext der Einführung neuer Unterrichtscurricula und Lehrformen genannt. Nach seiner Meinung sollten Neueinführungen zunächst mit einer kleinen Anzahl an Schülern erprobt werden, bevor sie flächendeckend implementiert werden. Dadurch resultiere ein geringer Schaden, wenn die Innovation sich als verbesserungswürdig herausstellen sollte. Gleichzeitig besteht die Möglichkeit der Veränderung und Anpassung.

Bei der Form der Prozess- oder Zwischenevaluation erfolgt eine kontinuierliche Weiterentwicklung und Optimierung eines Programms durch wirkungsbezogene Daten, die fortlaufend während der Programmdurchführung gesammelt werden. Diese erlauben eine Beurteilung der Erfolgsaussichten des Programms und können Veränderungen der Programmstruktur sowie der Programminhalte nahelegen. Gleichermaßen kann bei der Form der Implementationskontrolle formative Evaluation weniger auf die Ergebnisse und Maßnahmen, sondern vielmehr auf die Qualität der Umsetzung dieser Maßnahmen gerichtet sein. Wird eine Maßnahme wie geplant durchgeführt, ist auch die interne Validität des Evaluationsdesigns gewährleistet. Die Prüfung der Ausführungsintegrität (Treatment Fidelity) einer Intervention wird auch durch die Implementationskontrolle erreicht (vgl. Gollwitzer et al., 2007, S. 123 ff.).

Diese Beschreibungen verdeutlichen die Charakteristik formativer Evaluation. Durch die aus formativer Evaluation resultierenden Informationen können Entscheidungsprozesse im Projektmanagement beeinflusst werden. Durch dieses informelle Merkmal zeigt sich die Beziehung zwischen formativer Evaluation und der Führung komplexer Projekte.

Methoden

Formative Evaluation ist nicht hypothesentestend angelegt, sondern soll Schwachstellen in Projekten zielorientiert erkennen und schnell verändern. Sammlung, Auswertung und Evaluation von Daten erfolgen nach wissenschaftlichen Standards und Kriterien. Dabei verständigen sich Autoren der Evaluationsforschung auf den systemischen Ansatz. Dieser orientiert sich nicht ausschließlich an bestimmten Forschungsmethoden (z.B. quantitativ, qualitativ, experimentell oder ethnographisch, positivistisch, naturalistisch). Eine breite Skala von sozialwissenschaftlichen Paradigmen sollte maßgebend sein (vgl. Rossi et al. 1999, S. 1-35).

Prinzipiell unterscheidet sich Evaluation im Gesundheitsbereich hinsichtlich ihrer Zielsetzungen und Methoden kaum von der Evaluation in anderen Bereichen. Charakteristisch sind jedoch die Akteure, die institutionellen Rahmenbedingungen und die Art der Interventionen (vgl. Bengel, Koch 1988, S. 321 f., zit. n. Faßmann 2001, S. 134). Die Erhebung und Auswertung von Daten im Rahmen einer Evaluation muss methodischen Gütekriterien und Qualitätskriterien von Evaluation (Evaluationsstandards) entsprechen.

In der Evaluationspraxis der formativen Evaluation werden besonders qualitative aber auch quantitative Methoden angewendet. Bei der qualitativen Methode ist die Frage offen formuliert. Der Befragte muss sich an keine feste Antwortkategorie halten. Umso aufwändiger ist die Auswertungsarbeit, da die individuellen Antworttexte und Interviewaufzeichnungen einzeln analysiert und interpretiert werden müssen. Dagegen werden bei der quantitativen Methode der Evaluation hauptsächlich Größen erfasst, die sich in Zahlen ausdrücken lassen (Teilnehmer, Kursentgelte, Stundenzahl, etc.). Aber auch Merkmale die eigentlich „qualitativ“ erscheinen, können evtl. durch eine geeignete Skalierung in Zahlen ausgedrückt werden (vgl. Reischmann 2006, S. 35).

In Abhängigkeit von Zielen und Inhalten der Evaluation, aber auch vom Evaluationstyp, erfolgt die Auswahl der Evaluationsmethoden und der jeweils dazugehörigen Instrumente. Die Forschungsmethode der Handlungs- und Aktionsforschung kommt inhaltlich der formativen Evaluation nahe, bei der Veränderungsprozesse in der Praxis angestoßen werden sollen (vgl. Hart, Bond 2001, S. 69). Die Datenerhebung erfolgt bei einer formativen Evaluation durch folgende Möglichkeiten:

- Dokumenten- und Inhaltsanalyse (z.B. Auswertung von Protokollen und Dokumenten)

- schriftliche Befragungen (standardisiert oder halb-standardisiert, offene oder geschlossene Fragen)

- Interviews oder Expertengespräche (leitfadengestützt)

- Beobachtung (teilnehmend, nicht-teilnehmend, offen, verdeckt) (vgl. Neitzke et al. 2013, S. 153).

Dem Gesundheitswesen werden experimentelle Evaluationsdesigns (zwei Gruppen, Randomisierung, unabhängige Variable vom Forscher manipuliert) zugeschrieben (vgl. Nitsch, Waldherr 2011, S. 250). Da sich die Forschung mit Menschen befasst, ist das jedoch in vielen Gesundheitsbereichen, aus ethischen, organisatorischen und ökonomischen Gründen, nicht stringent durchführbar. Durch die Auswahl und/oder präzise Entwicklung von Instrumenten der Datenerhebung lässt sich jedoch ein objektives Bild vom Forschungsgegenstand machen. Die Erfahrungen zeigen, dass sich Erhebungs- und Analyseinstrumente, sowie Resultate, vor allem der qualitativen Sozialforschung, im Projektverlauf zu Katalysatoren von Reflexionsprozessen entwickeln können. Mit Hilfe der Evaluationsergebnisse können sie zeitnah und effektiv als Korrektiv in die Projektarbeit integriert werden (vgl. Hirschmann, Pfaff 2008, S. 94). Die Evaluationsstandards sind dabei so angelegt, dass sie für unterschiedliche Evaluationsansätze (formativ/summativ) offen sind (vgl. Beywl, Speer, Kehr 2004, S. 11).

Für weitere Definitionen von Begrifflichkeiten der Evaluation verweisen wir auf das Glossar von Dr. Beywl und Kollegen auf der Institutsseite http://www.univation.org/ .

Mit dem Glossar sollen die Klarheit der Evaluationsfachsprache sowie die Kommunikation unter Fachpersonen und an Evaluation Beteiligten gefördert werden. Vorschläge zur Fachterminologie von 425 eingestellten Begriffen sind öffentlich zugänglich.

Unter Werkzeuge http://www.univation.org/werkzeuge wird das Glossar wirkungsorientierter Evaluation erreicht. Hier stellt Univation die zweite, völlig überarbeitete und stark erweiterte Neuauflage des "Glossars wirkungsorientierter Evaluation" vor. Die Publikation umfasst 370 Fachbegriffe zur Evaluation mit einer Definiton, ihrem englischen Fachterminus sowie Literaturquellen zur weiteren Vertiefung.

Sie finden ausführliche Informationen zu den beiden Wikis, den Zielen von Univation sowie Ihren Mitarbeitsmöglichkeiten unter den folgenden Links:

www.eval-wiki.org/glossar und www.eval-wiki.org/werkstatt

Ebenso stellt das Landeszentrum für Gesundheit NRW Basiswissen und Praxisbeispiele für Evaluation in der Gesundheitsförderung sowie Prävention unter https://www.lzg.nrw.de/ges_foerd/qualitaet/evaluationstools/methodenkoffer/index.html vor. Somit können wichtige Begriffe der Evaluationsforschung, von den Rahmenbedingungen, den Evaluationsmodellen, der Ausrichtung, dem Zeitpunkt der Evaluation, dem Durchführungsmodi und der Metaevaluation, für die Planung und Durchführung von Evaluationsprojekten recherchiert sowie konkretisiert werden.

Tools für die Praxis

Modelle und Instrumente der Evaluation

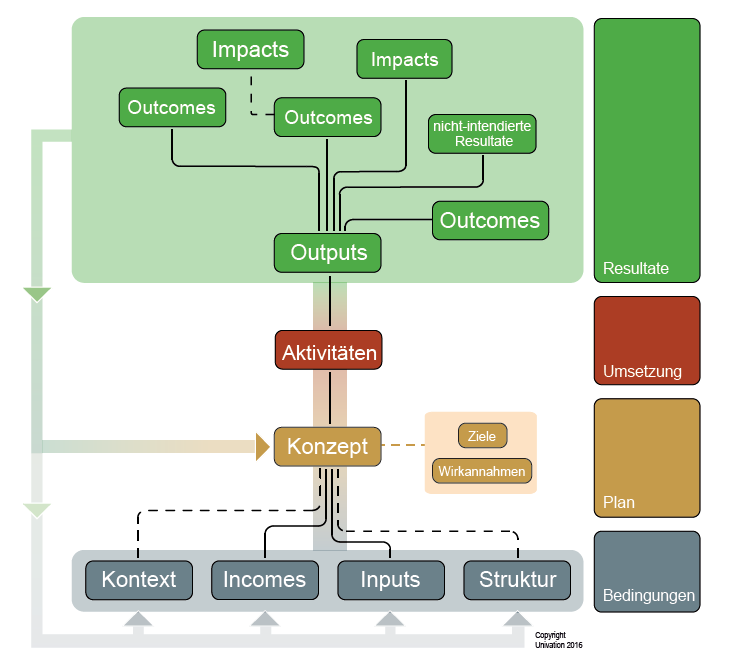

Evaluationsmodell - Programmbaum der Evaluation

Der Programmbaum ist ein durch Wolfgang Beywl und Univation entwickeltes logisches Programmmodell. Sein Einsatz strukturiert Evaluationen und Beratungen. Evaluierende nutzen ihn bei Gegenstandsbeschreibung und Kontextanalyse, Designentwicklung und Kommunikation.

Programmverantwortliche prüfen und entwickeln mit ihm die Konzeptqualität ihrer Vorhaben. Sein Einsatz sichert einen hohen Prozessnutzen der Evaluation. Abbildung, Beispiele und Erläuterungen der einzelnen Elemente finden Sie unter: http://www.univation.org/programmbaum .

Abbildung: Der Programmbaum und seine Elemente

Online unter: http://www.univation.org/programmbaum (Abruf am 04.05.2018)

Evaluationsstandards der Gesellschaft für Evaluation

Um den Gütekriterien von Evaluation zu entsprechen verweisen wir auf die Evaluationsstandards der DeGEval.

Evaluationsstandards beschreiben wie eine Evaluation auszugestalten ist, damit sie eine hohe Qualität aufweist. Sie dienen insbesondere zur Orientierung für die Durchführung von Evaluationen und die Vergabe sowie Beurteilung von Evaluationen.

Die Gesellschaft für Evaluation, zu deren Gründungsmitgliedern Univation zählt, verfügt seit 2001 über ein Set von Standards. Hier kann eine revidierte Fassung von 2016 sowie eine Checkliste zur Anwendung der Evaluationsstandards heruntergeladen werden.

Darüber hinaus finden Sie Empfehlungen durch die DeGEval, wie die Standards für Evaluation im Handlungsfeld der Selbstevaluation eingesetzt werden sollten. (https://www.degeval.org/publikationen/selbstevaluation/)

Das Joint Committe hat 2010 eine weitere Neufassung der Evaluationsstandards veröffentlicht. Deren Kurzfassung liegt in übersetzter Form unter http://www.zora.uzh.ch/id/eprint/63498/1/JCSEE-Standards_2012.pdf vor.

Wolfgang Beywl hat eine weitere Version vorgelegt, in der die Anwendung der neuen Joint-Committe-Standards für den Bereich Schulen veranschaulicht wird:

http://www.univation.org/sites/default/files/standards-kurzfassung_v24_schulversion_eno.pdf

Zudem hat die Amerikanische Evaluationsgesellschaft (AEA) Leitlinien für Evaluatorinnen und Evaluatoren erarbeitet. Sie wurden 2004 überarbeitet und stehen Ihnen in der aktuellen Version in einer deutschen Übersetzung unter http://www.univation.org/download/leitprinzipienaea-uebersetzt-2006.pdf zur Verfügung.

Checklisten zur Evaluation

Instrumente zur Unterstützung von Stakeholdern können verschiedene Checklisten darstellen. Univation bieten auch hier auf ihrer Online - Seite eine Sammlung von Checklisten, die Evaluierende und Auftraggebende bei ihrer Arbeit unterstützen können. Diese stammen aus verschiedenen Quellen und werden jeweils mit Zustimmung der Verfassenden auf der Seite http://www.univation.org/checklisten veröffentlicht.

In drei Kategorien werden eine Vielzahl von Checklisten angeboten.

- Evaluation Checklist Project des Evaluation Center an der Western Michigan University (USA) http://www.wmich.edu/evaluation/checklists

- Checklisten in deutscher Übersetzung (z. B. Evaluationsdesign und –management, Evaluationsmodelle, Institutionalisierung, Werte und Kriterien, Meta-Evaluation, Evaluationsvermögen, Checklisten-Entwicklung) http://www.univation.org/checklisten

- Checklisten aus dem deutschsprachigen Raum (z. B. Selbstevaluation, Planung von Projekt- und Programmevaluation - Bundesamt für Gesundheit der Schweiz, Alexandra Caspari - Lernen aus Evaluierungen, Fachhochschule Nordwestschweiz und Univation, Gesellschaft für Evaluation (DeGEval), Checklisten für Auftraggebende - aus dem Leitfaden für die Schweizer Bundesverwaltung, Bundesamt für Gesundheit der Schweiz http://www.univation.org/checklisten

Instrumente in der Selbstevaluation

Hier verweisen wir auf die Online-Seite www.selbstevaluation.de . Univation hat in Kooperation mit Dr. Rüdiger Preißer und socialnet das Portal in konzeptioneller und gestalterischer Hinsicht überarbeitet.

Die Seite richtet sich an ein breites Publikum und soll durch zahlreiche Praxisbeispiele und Literaturhinweise zum Einsatz von Selbstevaluation anregen.

Auf der Website wird eine Wissensbasis über die Methodologie und Anwendungspraxis der Selbstevaluation für Praktikerinnen und Praktiker bereitgestellt. Dazu wird das bisher verstreute Wissen aus Fachpublikationen über Selbstevaluation zusammenfassend dargestellt und Materialien aus den Anwendungsfeldern der Selbstevaluation sowie themenrelevante Publikationen vorgestellt. Schließlich gibt es Hinweise auf Weiterbildungsmöglichkeiten zur Selbstevaluation.

http://www.univation.org/selbstevaluation und http://www.selbstevaluation.de/

Qualitätssicherungsinstrumente in der Evaluation

Materialien zur Qualitätssicherung. Herausgegeben vom Bundesministerium für Familie, Senioren, Frauen und Jugend (BMFSFJ)

Online unter http://www.univation.org/qs-hefte finden Sie die gesamte Reihe der „Materialien zur Qualitätssicherung in der Jugendhilfe“ (Qs-Hefte), die Ihnen mit freundlicher Erlaubnis des BMFSFJ hier zum Download zur Verfügung stellen.

Basiswissen Qualität und Qualitätsinstrumente in Gesundheitsförderung und Prävention findet sich unter https://www.lzg.nrw.de/ges_foerd/qualitaet/basiswissen/index.html des Landeszentrums für Gesundheit NRW.

Quellensammlung Evaluation

Die Quellensammlung www.eval-wiki.org/Quellensammlung soll Evaluierenden, Auftraggebenden und an Evaluation Interessierten als Übersicht onlinebasierter Informations- und Selbstlernmöglichkeiten dienen. Über "Eintrag hinzufügen" haben Sie die Möglichkeit, weitere Quellen zur Sammlung vorzuschlagen.

Auf der Homepage der Gesellschaft für Evaluation (DeGEval) finden sich u.a. Informationen zu Leitfäden, Evaluationsgesellschaften weltweit, Portalen, Diskussionslisten und Literatur im Evaluationsbereich. http://www.degeval.de/links

In englischer Sprache sammelt der Evaluator Lars Balzer aktuelle Informationen und Links rund um Evaluation und gliedert die Informationen in den Kategorien Links, Termine/Kalender und Literatur. http://www.evaluation.lars-balzer.name/

Weitere nützliche Hilfen, Buchtipps und Materialien in der Evaluation

- Signifikanztests in der Evaluation

Im Team von Univation wird seit längerem darüber diskutiert, wann Signifikanztests gerechnet und in Berichten ausgewiesen werden sollen. Hierzu gibt es eine Stellungnahme und die Möglichkeit der Beteiligung an einer Diskussion im forum-evaluation http://www.univation.org/signifikanztests-evaluation.

- Eva die Evaluatorin - ein Evaluationsbilderbuch

"Eva die Evaluatorin" ist ein richtiges Kinder-Bilderbuch. Und es hat einen zweiten Wert: Es kann genutzt werden, um Auftraggebenden und anderen Beteiligten die Rolle von Evaluation zu erklären.

- Qualitätsdimensionen

Die fünf Dimensionen der Qualität wurden von Dr. Wolfgang Beywl 1996 veröffentlicht. Dieser Link führt zu einer flash-animierten Version zum leichten Verständnis der Qualitätsdimensionen. http://www.univation.org/qualitaetsdimensionen

- Literatur- und Forschungsdatenbanken in der Evaluation

Evaluatorinnen und Evaluatoren müssen oft in knapper Zeit Literatur und vorliegende Evaluationen/Forschungen zu speziellen Themen recherchieren. Dazu stehen im deutschsprachigen und insbesondere im englischsprachigen Raum zahlreiche Datenbanken zur Verfügung. Die vorliegende Sammlung von Datenbanken soll als Orientierungshilfe für die Suche nach evaluationsspezifischen Inhalten dienen und gleichzeitig Hinweise zur Weiterentwicklung der Datenbanken aus Sicht der Bedarfe der Evaluationsdisziplin geben.

Die Sammlung umfasst 43 Datenbanken und Portale, die für die Bearbeitung evaluativer Fragestellungen nutzbringend sein können und zum Großteil kostenfrei über eine Universitätsbibliothek zu recherchieren sind.

Die erfassten Datenbanken und Portale stammen aus dem deutschen und englischen Sprachraum und sind in den Bereichen Sozialwissenschaften, Wirtschaftswissenschaften, Psychologie, Gesundheitswesen/Medizin, Bildung, Kinder- und Jugendhilfe sowie Technologieevaluierung angesiedelt. Sie können unter http://www.univation.org/literatur-forschungsdatenbanken-evaluation heruntergeladen werden.

Anwendung von Informationstechnik im Projektmanagement und als Instrument formativer Evaluation

Informationstechnologie in Form von Software macht Projekte oder Evaluationen nicht erfolgreicher, besser, schneller oder effizienter. Nach Müller und Sontow erhöht sich mit ihrem Einsatz jedoch die Wahrscheinlichkeit der Einhaltung von Zielgrößen wie Kosten, Zeit und Qualität (vgl. Müller, Sontow, 1995, S. 234-238).

Besonders wenn Detail-, Mittel- und Endziele erreicht werden müssen, wird Software im Projektmanagement benötigt. Hierbei greifen viele Komponenten ineinander und müssen einbezogen werden. Darunter fallen Terminpläne, Ressourcen aller Art und Zeitrahmen. Den Überblick über Projektabläufe zu behalten und diese zu organisieren wird schwieriger, je länger und komplexer diese Projekte sind. Es wird davon ausgegangen, dass im Projektmanagement Software von Nutzen sein kann. Dazu sollte sie von der Projektplanung bis zum Projektabschluss in allen Projektphasen zur Verfügung stehen. Software unterstützt Projektmanagementverantwortliche bei Prozessen der Termin- und Ressourcenplanerstellung sowie ihrer flexiblen Verwaltung, im Controlling und der Dokumentation sowie in der Kommunikation (vgl. Eller, Rosen, 2012, S. 67).

In der Projektmanagement-Literatur werden zwischen 150-300 Softwarelösungen publiziert. Gründe für diese Unterschiede liegen nach Worms zum Teil in der Schwierigkeit der unklaren inhaltlichen Definition von Software für das Projektmanagement und von Projektmanagement-Software. Die Anforderungen an Projektmanagement-Software sind komplex. Das begründet die Vielzahl an Softwarelösungen im Projektmanagement. Unterschieden wird in Single-Project-, Multi-Project-, Plan-oriented Multi-Project-, Process-oriented Multi-Project-, Resource-oriented Multi-Project- und Service-oriented Multi-Project-Management Systems (vgl. Worms, 2011, S 5f). Von einfachen Office-Tools, wie z.B. Tabellenkalkulationen, bis hin zu komplexen Programm- oder Portfolio-Tools, in Form von Enterprise-Resource-Planning-System (ERP), wird ein breites Spektrum abgedeckt (vgl. Ortner, Stur, 2015, S. 65). Kriterien zur IT-Anwendung in Projekten sind u.a. Projektgröße, Projektart, Nutzungsebene im Projektmanagement und Projektphasen.

Beispiele von Projektmanagement-Software werden z. B im “Projekt-Magazin“ unter https://www.projektmagazin.de/projektmanagement/software/software-besprechungen vorgestellt.

Im Bereich der formativen Evaluation verweisen wir gern auf unsere Lehrevaluation mit der Hochschulsoftware EvaSys.

Zu den großen der Herausforderungen der Lehre an der Hochschule sowie in den verschiedenen Fort- und Weiterbildungen der Steinbeis-Hochschule Berlin sowie der Deutschen Gesellschaft für Gesundheit und Pflegewissenschaft (DGGP) gehört die Lehrevaluation.

Der hier genannte Qualitätsbegriff kann durch folgende Fragen genauer beschrieben werden.

- Was ist guter Unterricht?

- Was macht die erfolgreiche Lehrperson aus?

- Wie kann man die Qualität des Unterrichts erfassen und bewerten?

- Wie lassen sich Unterricht und Unterrichtsbedingungen verbessern?

Die Qualität im Sinne von „Güte“ des Unterrichts bemisst sich daran, ob auf Seiten der Seminarteilnehmer Lernprozesse initiiert werden und wie nachhaltig diese sind.

Um Qualität zu gewährleisten setzt die Steinbeis Hochschule Berlin und die Deutsche Gesellschaft für Gesundheit und Pflegewissenschaft Maßnahmen ein, mit Hilfe derer sie die Bedingungen in Studium und Lehre kontinuierlich evaluiert und damit qualitative Entwicklungspotenziale erkennen kann.

Der formative Evaluationsansatz ist in der Lehrevaluation von großer Bedeutung und wird entsprechend der Fragestellung und Zielformulierung intensiv genutzt.

Bei Interesse bzgl. Informationen des IT–Einsatzes in komplexen Projekten mit Bezug auf Gesundheit können Sie gerne Kontakt mit uns aufnehmen (info@dggp-online.de). Diese sind aus umfangreichen qualitativen und quantitativen Datenerhebungen hervorgegangen.

Literaturverzeichnis

Beywl W, Wiedmer T (2009): Evaluation in Expansion: Ausgangslage für den intersektoralen Dreiländer-Vergleich, In Carlo F (Hrsg.): Evaluation - ein systemisches Handbuch, 1.Auflage, Wiesbaden: VS Verlag für Sozialwissenschaften, GWV Fachverlage GmbH

Beywl, W., Speer, S., Kehr, J., Univation - Institut für Evaluation Dr. Beywl & Associates GmbH ; Bundesministerium für Gesundheit und Soziale Sicherung (Ed.): Wirkungsorientierte Evaluation im Rahmen der Armuts- und Reichtumsberichterstattung: Perspektivstudie. Köln, 2004 (Forschungsbericht / Bundesministerium für Arbeit und Soziales A323). Online unter: http://nbn-resolving.de/urn:nbn:de:0168-ssoar-316312; (Abruf am 07.05.2018)

Balzer, L.: Evaluationsportal, Online unter: http://www.lars-balzer.info/

Balzer, L. (2005): Wie werden Evaluationsprojekte erfolgreich? Ein integrierender theoretischer Ansatz und eine empirische Studie zum Evaluationsprozess. Landau: Verlag Empirische Pädagogik

Bär, G. (2013): Wissenschaftliche Begleitung, formative Evaluation und partizipative Forschung. Methodische Fußangeln für Wissenschafts-Praxis-Partnerschaften. In: Prävention und Gesundheitsförderung, Heft 3, Online publiziert: 25. Juni 2013, S. 155–162, Berlin, Heidelberg: Springer Verlag

Bitzan M. (2008): Praxisforschung, wissenschaftliche Begleitung, Evaluation: Erkenntnis als Koproduktion. In: Handbuch Frauen- und Geschlechterforschung. Theorie, Methoden, Empirie 2. erweiterte und aktualisierte Auflage, Becker R., Kartendiek B. (Hrsg.), Wiesbaden: VS Verlag für Sozialwissenschaften, Springer Verlag

Bortz, J./Döring, N. (2006): Forschungsmethoden und Evaluation, 4., überarbeitete Auflage, Heidelberg: Springer Medizin Verlag

Deutsche Gesellschaft für Evaluation, DeGEval, Online unter: https://www.degeval.org/home/

DeGEval - Deutsche Gesellschaft für Evaluation e. V. (2008): Standards für Evaluation., Online unter: http://www.degeval.de/fileadmin/user_upload/Sonstiges/STANDARDS_2008-12.pdf (Abruf am 09.05.2018)

Eller, D./Rosen, W. (2012): Projekte realisieren - Projektmanagement. In: Schneidereit U. (Hrsg.): EduMedia, 1. Auflage, Stuttgart: EduMedia GmbH, Verlag für Aus- und Weiterbildung

Evaluationssoftware, EvaSys, Online unter: https://www.evasys.de/startseite.html

Eval-Wiki (2015): wissenschaftliche Begleitforschung, Im Internet unter: http://eval-wiki.org/glossar/Begleitforschung,_wissenschaftliche; (Abruf am 07.05.2018)

Faßmann, H. (2001): Forschungspraktische Probleme der Evaluation von Programmen im Bereich der Rehabilitation. In: Sozialwissenschaften und Berufspraxis 24, 2, S. 133–149, Online unter: http://nbn-resolving.de/urn:nbn:de:0168-ssoar-37655 (Abruf am 05.05.2018)

Gollwitzer M., Jäger R. S. (2009): Evaluation Kompakt, 1. Auflage, Weinheim, Basel: Beltz Verlag

Hart E., Bond M. (2001): Aktionsforschung, Handbuch für Pflege-, Gesundheits- und Sozialberufe, Bern: Verlag Hans Huber

Hirschmann, K./Pfaff, N. (2008): Reflexion und Moderation, Erfahrungen aus einer partizipativen Evaluationsstudie in der politischen Bildung. In: Sozialwissenschaften und Berufspraxis (SuB), 31. Jg., Heft 1, S. 94-–108

Kromrey, H. (2001): Evaluation – ein vielschichtiges Konzept Begriff und Methodik von Evaluierung und Evaluationsforschung. Empfehlungen für die Praxis. In: Sozialwissenschaften und Berufspraxis, 24. Jg., Heft 2/2001 S. 2

Kromrey, H. (2006): Empirische Sozialforschung. Modelle und Methoden der standardisierten Datenerhebung und Datenauswertung. 11. überarbeitete Auflage, Stuttgart: Lucius & Lucius Verlagsgesellschaft mbH

Landeszentrum Gesundheit NRW, Online unter: https://www.lzg.nrw.de/index.html

Mayring, P. (2002): Einführung in die qualitative Sozialforschung. Eine Anleitung zu qualitativem Denken. 5. Auflage, Weinheim: Beltz Verlag

Mayring P. (2009): Evaluation im Bereich Gesundheit - Beispiel Deutschland. In: Evaluation - ein systematisches Handbuch. Fabian C., Beywl W., Wiedmer T. (Hrsg.). Wiesbaden: VS Verlag für Sozialwissenschaften | GWV Fachverlage GmbH

Müller, S./Sontow, K. (1995): Kosten sparen mit Projektmanagementsoftware. In: Zeitschrift Magazin für Computertechnik, Heft 10, S. 234-238

Neitzke, G./Riedel, A./Dinges, S./Fahr, U./May, A. T. (2013): Empfehlungen zur Evaluation von Ethikberatung in Einrichtungen des Gesundheitswesens. In: Ethik Medizin, 25, S. 149–156, online publiziert: 07.12.2012, Springerlink.com

Nitsch M., Waldherr K. (2011): Evaluation von Gesundheitsfördernden Schulen. In Zeitschrift: Prävention und Gesundheitsförderung, Heft 6, S. 249 - 254, Online publiziert: 6.Juli 2012, Springer Verlag

Ortner, G., Stur, B. (2015): Das Projektmanagement-Office. Einführung und Nutzen, 2., überarbeitete Auflage, Berlin Heidelberg: Springer Gabler Verlag

Projektmagazin (2016): Das Fachportal für Projektmanagement. Software, Im Internet veröffentlicht unter: https://www.projektmagazin.de/projektmanagement-software/liste; (Abruf am 04.05.2018)

Reinmann, G. (2012): Studientext Evaluation, München: Universität der Bundeswehr, Online unter: http://gabi-reinmann.de/wp-content/uploads/2013/ 05/Studientext_2012_Evaluation.pdf (Abruf: 08.05.2018)

Reischmann J. (2006): Weiterbildungsevaluation. Lernerfolge messbar machen, Neuwied: Luchterdand Verlag

Roth E. (1993): Sozialwissenschaftliche Methoden. Lehr- und Handbuch für Forschung und Praxis, 3., völlig überarbeitete und erweiterte Auflage, München: Oldenbourg Wissenschaftsverlag GmbH

Rossi P., Freemann H. E., Lipsey M. E. (1999): Evaluation. A systemic approach. London: Sage Publication

Sischka K. (2012): Zum Nutzen eines konfliktsensiblen Ansatzes in der wissenschaftlichen Begleitung. In: Strobel R. et al. (Hrsg.): Evaluation von Programmen und Projekten für eine demokratische Kultur. Wiesbaden: Springer Fachmedien Verlag

Stockmann, R. (2004): Was ist eine gute Evaluation? Einführungen zu Funktionen und Methoden von Evaluationsverfahren. CEval Arbeitspapier 9, Universität des Saarlandes, Saarbrücken: Zentrum für Evaluation, Online unter: http://www.ceval.de/modx/fileadmin/user_upload/PDFs/workpaper9.pdf (Abruf am 04.05.2018)

Stockmann, R./Meyer, W. (2014): Evaluation, Eine Einführung, 2., überarbeitete und aktualisierte Auflage, Opladen & Toronto: Verlag Barbara Budrich

Univation - Institut für Evaluation Dr. Beywl & Associates GmbH, Online unter: http://www.univation.org/

Wesseler, M. (2009): Evaluation und Evaluationsforschung. Tippelt. R./Hippel, A. v (Hrsg.): Handbuch Erwachsenenbildung/Weiterbildung, 3., überarbeitete und erweiterte Auflage, Wiesbaden: VS Verlag für Sozialwissenschaften, GWV Fachverlag GmbH

Worms, H. (2011): Softwareeinsatz im Veränderungsmanagement - Möglichkeiten und Grenzen. Studienarbeit, Hochschule Magdeburg-Stendal (FH), Standort Stendal, Fachbereich: Wirtschaft

Wottawa, H./Thierau, H. (1998): Lehrbuch Evaluation. 2., vollständig überarbeitete Auflage, Bern: Verlag Hans Huber